Nogle ændringer kan være så store, og samtidig gå næsten ubemærket hen. Tænk på klimaforandringer, hvor små stigninger i temperaturen er svære at mærke til daglig, men det har alligevel en stor indflydelse på vores liv. Google Hummingbird Update er lidt at sammenligne med dette, selvom der dog stadig er langt fra en søgemaskine til klimaforandringer. Hummingbird er blevet beskrevet som en af de største opdateringer på Google siden 2001, og fokus var hastighed og præcision. At håndtere store mængder af data på internettet, og så skulle matche det op med søgeord kan være en stor opgave, og i starten fokuserede Google på at matche søgeord med indholdet 1 til 1. Det ændrede sig dog med Hummingbird, hvor Google nu blev bedre til at afkode overemnet for ens søgeord, og derfor matche søgeresultaterne til dette. I modsætning til Penguin og Panda, så var Hummingbird ikke en tilføjelse til hovedalgoritmen – det var derimod en ændring af selve algoritmen.

Nogle ændringer kan være så store, og samtidig gå næsten ubemærket hen. Tænk på klimaforandringer, hvor små stigninger i temperaturen er svære at mærke til daglig, men det har alligevel en stor indflydelse på vores liv. Google Hummingbird Update er lidt at sammenligne med dette, selvom der dog stadig er langt fra en søgemaskine til klimaforandringer. Hummingbird er blevet beskrevet som en af de største opdateringer på Google siden 2001, og fokus var hastighed og præcision. At håndtere store mængder af data på internettet, og så skulle matche det op med søgeord kan være en stor opgave, og i starten fokuserede Google på at matche søgeord med indholdet 1 til 1. Det ændrede sig dog med Hummingbird, hvor Google nu blev bedre til at afkode overemnet for ens søgeord, og derfor matche søgeresultaterne til dette. I modsætning til Penguin og Panda, så var Hummingbird ikke en tilføjelse til hovedalgoritmen – det var derimod en ændring af selve algoritmen.

Med en større sprogforståelse blev det nu muligt for Google at greje intentionen bag en søgning bedre, og derved kunne leveres mere relevante søgeresultater til brugeren. Matt Cutts fra Google har også udtalt, at Hummingbird påvirkede op mod 90% af alle søgninger. Dette gjorde den blandt andet ved at kunne udvælge de mest relevante ord i især lange søgetermer.

Forbrugslån, casinosider, affiliate og spam – Disse kæmper Google stadig med

Forbrugslån, casinosider, affiliate og spam – Disse kæmper Google stadig med

En af de ting, der går igen gennem rigtig mange af Googles opdateringer, er den evige kamp mod alle former for lyssky forretninger. Med PayDay Loan Update blev der stillet skarpt på de sider, som tilbød lån og casino, porno og andre sider, hvor der typisk optræder meget spam. Opdateringen rullede ud i 2013, og blev indført over en to måneder lang periode. Opdateringen fik en ændring i 2014.

En af de ting, der går igen gennem rigtig mange af Googles opdateringer, er den evige kamp mod alle former for lyssky forretninger. Med PayDay Loan Update blev der stillet skarpt på de sider, som tilbød lån og casino, porno og andre sider, hvor der typisk optræder meget spam. Opdateringen rullede ud i 2013, og blev indført over en to måneder lang periode. Opdateringen fik en ændring i 2014.

Også Googles Quality Update gik efter sider, som ikke tilbød indhold af høj nok kvalitet, dårlige links og spamindhold. Denne landede i 2015, og gik især efter tyndt indhold, clickbait artikler, sider med enorme mængder af reklamer, content farm-artikler og masseproducerede ”How to”-sider. Kort sagt så gik denne opdatering direkte efter de sider, som simpelthen ikke leverede indhold af høj nok kvalitet til forbrugeren.

Det har længe været en del af Googles strategi at skubbe de sider frem, som rent faktisk gav godt, relevant og aktuelt indhold til forbrugeren, samtidig med at hjemmesiden var brugervenlig.

Og hvad kan vi så lære af alt dette?

Som én, der arbejder med SEO, så kan det godt virke som en udfordring at skulle bygge en hjemmeside op, så den passer til alle Googles mange kriterier. Der kommer hele tiden nye opdateringer, og Google er gået helt væk fra at navngive dem. Nu hedder de alle sammen bare Fred. Hvis du følger med i diverse SEO-fora, så er disse tit engelske. Det betyder også, de tit tager udgangspunkt i lande, hvor der er langt flere søgninger og højere volumen på de fleste søgeord. Det kan derfor være svært at oversætte alle disse best practices til danske forhold. Så hvad kan vi bruge historien om de mange opdateringer til?

Som én, der arbejder med SEO, så kan det godt virke som en udfordring at skulle bygge en hjemmeside op, så den passer til alle Googles mange kriterier. Der kommer hele tiden nye opdateringer, og Google er gået helt væk fra at navngive dem. Nu hedder de alle sammen bare Fred. Hvis du følger med i diverse SEO-fora, så er disse tit engelske. Det betyder også, de tit tager udgangspunkt i lande, hvor der er langt flere søgninger og højere volumen på de fleste søgeord. Det kan derfor være svært at oversætte alle disse best practices til danske forhold. Så hvad kan vi bruge historien om de mange opdateringer til?

Google har her i august rullet Helpful Content ud, som sigter efter at fremme sider med brugervenligt indhold, og på samme tid skubbe søgemaskineoptimeret indhold bagud. Google har i samme omgang fremhævet deres egen guide til, hvordan du sikrer, at indholdet på din hjemmeside er rettet mod læseren fremfor søgemaskinen selv.

1. Hold dig til dit vidensfelt

Det siger måske sig selv, at hvis din hjemmeside handler om kæledyr, så skal du ikke lige pludselig skrive stolpe op og stolpe ned om forkølelser, økonomi, sport eller lignende. Kort sagt skal du holde dig til dét, som du rent faktisk ved noget om.

Det siger måske sig selv, at hvis din hjemmeside handler om kæledyr, så skal du ikke lige pludselig skrive stolpe op og stolpe ned om forkølelser, økonomi, sport eller lignende. Kort sagt skal du holde dig til dét, som du rent faktisk ved noget om.

2. Skriv om dét, som du har direkte erfaring med

At anbefale produkter, som du ikke selv har haft i hænderne, kan være fristende for at ramme søgeord med høj volumen, og samtidig promovere noget der kan være stor fortjeneste på. Det er dog også samme taktik som affiliate-sider benytter, og denne form for indhold hjælper altså ikke brugeren. For du har ikke den nødvendige erfaring eller viden om produktet til at have autoriteten til at anbefale det.

At anbefale produkter, som du ikke selv har haft i hænderne, kan være fristende for at ramme søgeord med høj volumen, og samtidig promovere noget der kan være stor fortjeneste på. Det er dog også samme taktik som affiliate-sider benytter, og denne form for indhold hjælper altså ikke brugeren. For du har ikke den nødvendige erfaring eller viden om produktet til at have autoriteten til at anbefale det.

3. Hold dig til ét emne

Din hjemmeside skal holde sig til sit hovedfokus, og ikke skyde med spredehagl. Lad dig ikke friste af ønsket om at rangere på mange forskellige søgeord, men hold dig til dit fokusområde. Det gør både din hjemmeside mere brugervenlig for læseren, og det er nemmere for Google at definere, hvad din side egentlig handler om.

Din hjemmeside skal holde sig til sit hovedfokus, og ikke skyde med spredehagl. Lad dig ikke friste af ønsket om at rangere på mange forskellige søgeord, men hold dig til dit fokusområde. Det gør både din hjemmeside mere brugervenlig for læseren, og det er nemmere for Google at definere, hvad din side egentlig handler om.

4. Sørg for at have fyldestgørende svar på relevante spørgsmål

Hvis vi tager fat i eksemplet med kæledyr igen, så kan der være mange spørgsmål, man som læser kan have. Det kunne være spørgsmål om, hvad man skal have i huset, inden man anskaffer sig en hund, hvad man skal være opmærksom på, hvis ens hund bliver syg, hvor meget vand skal den drikke om dagen og så videre. For at sikre, at din læser får den nødvendige viden fra din hjemmeside, så kan du spørge dig selv: vil læseren have behov for at søge videre, efter at have læst indholdet på din side?

Hvis vi tager fat i eksemplet med kæledyr igen, så kan der være mange spørgsmål, man som læser kan have. Det kunne være spørgsmål om, hvad man skal have i huset, inden man anskaffer sig en hund, hvad man skal være opmærksom på, hvis ens hund bliver syg, hvor meget vand skal den drikke om dagen og så videre. For at sikre, at din læser får den nødvendige viden fra din hjemmeside, så kan du spørge dig selv: vil læseren have behov for at søge videre, efter at have læst indholdet på din side?

5. Tænk over helhedsoplevelsen for din læser

Din hjemmeside skal tilbyde fyldestgørende informationer, og det kan være relevant at inddrage alt fra tekst til billeder og video. Ligegyldigt om du skriver en produktanmeldelse, forklarer hvad du skal sikre dig, inden du får din første hund eller noget helt tredje. Det er vigtigt at holde helhedsoplevelsen for øje. Tænk over dine egne oplevelser, når du surfer rundt på nettet.

6. Lad være med at besvare spørgsmål, som ikke har noget bekræftet svar

At tage emner op, som ikke har endelige svar eller går imod videnskabelig konsensus kan være en farlig leg. Det er ikke noget, som du nødvendigvis skal afholde dig fra 100% – men det er vigtigt, at du gør det tydeligt for læseren, at du ikke har det endelige svar på spørgsmålet.

7. Sørg for, at du overholder de guidelines, der er kommet med alle Googles tidligere opdateringer

Som dette lange blogindlæg kan bekræfte, så er der mange opdateringer, og de har alle haft deres eget formål og sæt af retningslinjer, som har formet søgemaskinen. Det er vigtigt, at du er opmærksom på alle disse, og gør dit bedste for at overholde dem.

Google Grump Rating – Er Google chill eller furious?

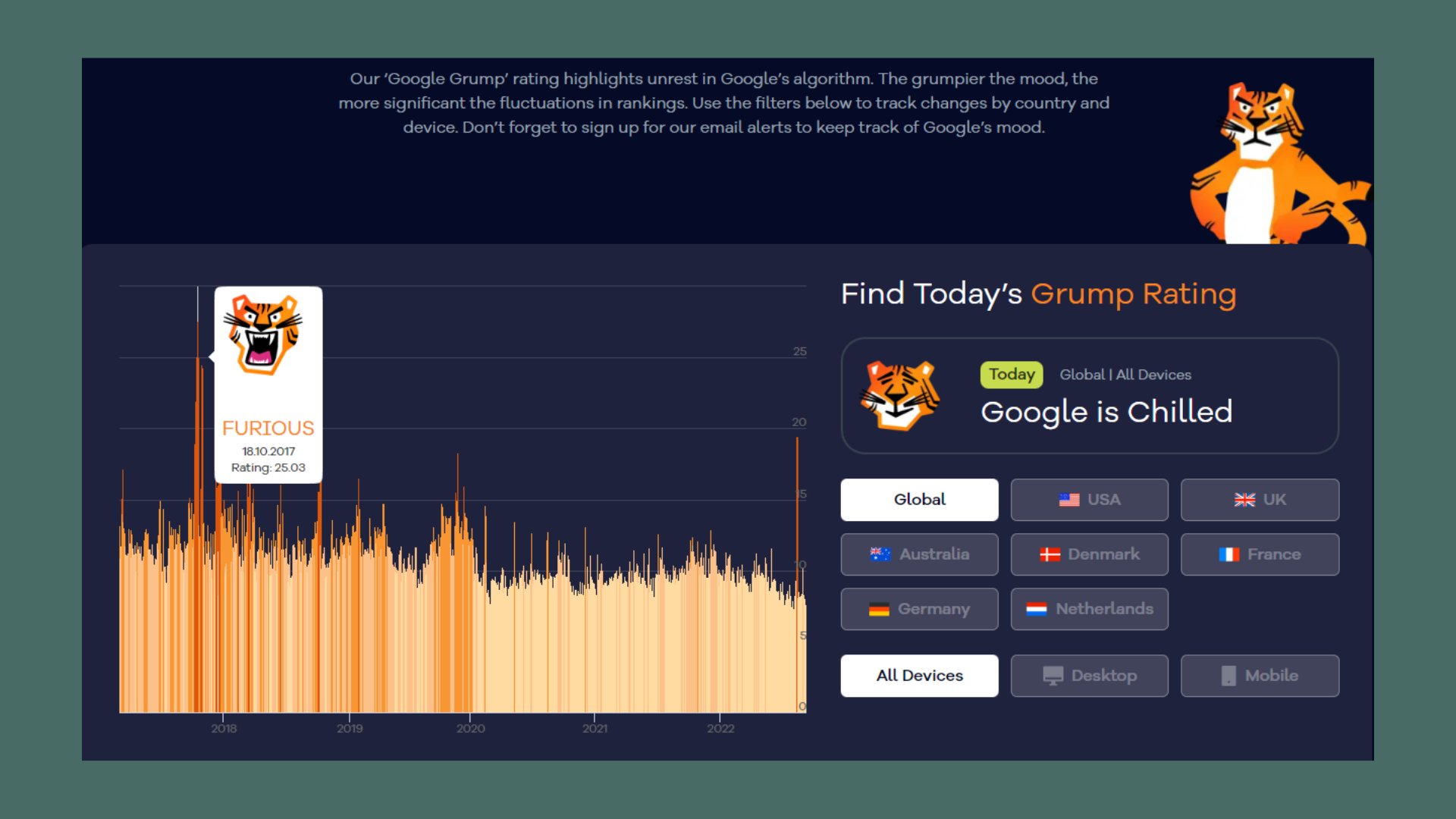

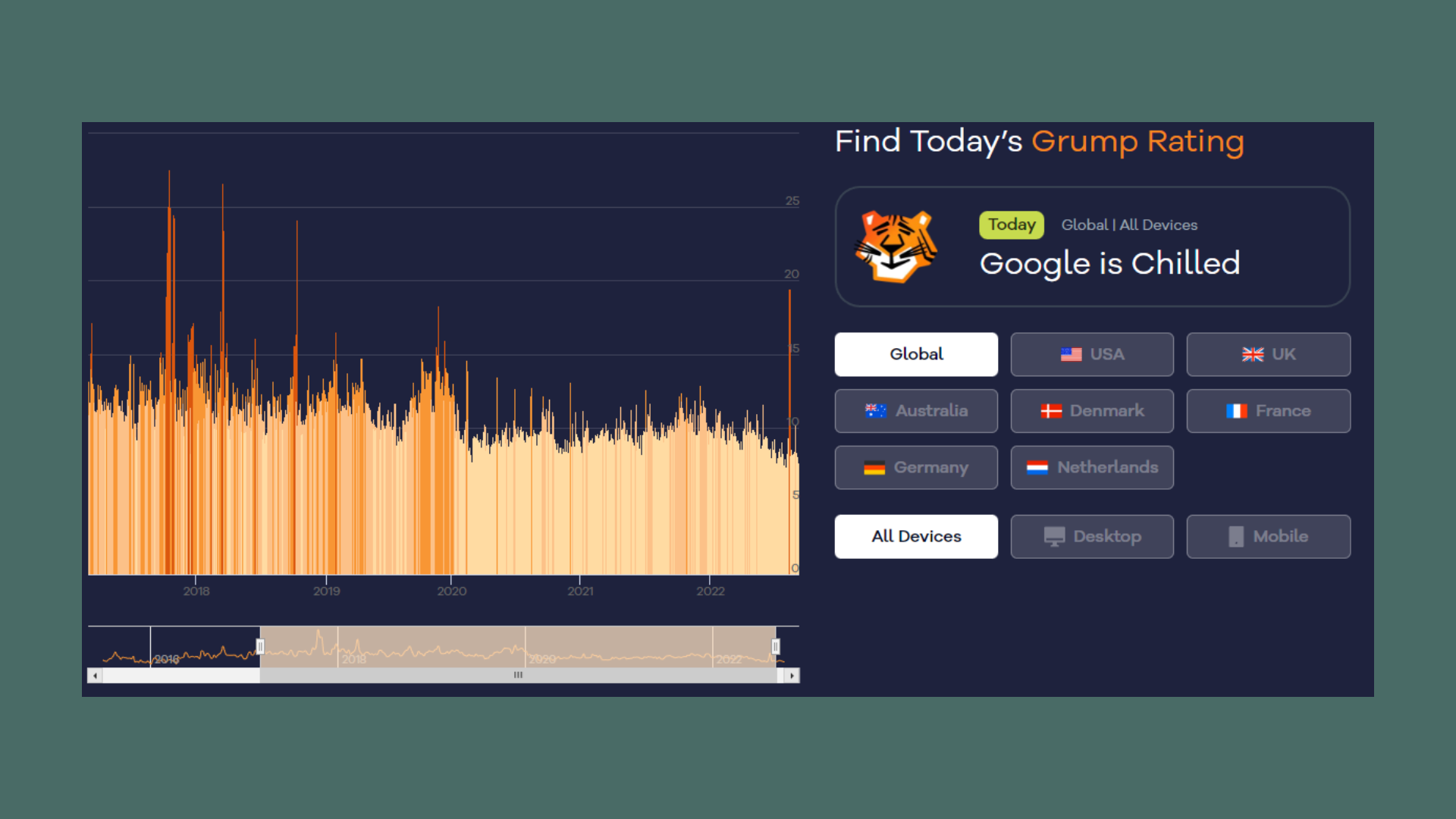

Et af mine personlige yndlingsværktøjer er Google Grump Rating, som er en feature, du kan finde hos Accuranker. Her har siden holdt øje med betydelige udsving i Googles rangering af sider, og det giver et lille indblik i, hvor meget de forskellige opdateringer har rodet med søgemaskinen. Dataen går tilbage til juni 2015, så vi har desværre ikke en fin graf over, hvad der er sket under nogle af de største opdateringer. Men vi kan følge med fremadrettet.

Et af mine personlige yndlingsværktøjer er Google Grump Rating, som er en feature, du kan finde hos Accuranker. Her har siden holdt øje med betydelige udsving i Googles rangering af sider, og det giver et lille indblik i, hvor meget de forskellige opdateringer har rodet med søgemaskinen. Dataen går tilbage til juni 2015, så vi har desværre ikke en fin graf over, hvad der er sket under nogle af de største opdateringer. Men vi kan følge med fremadrettet.

På billedet nedenfor kan du se, hvor rasende Google var i oktober 2017, hvilket passer med, at Google ser ud til at have smidt endnu en opdatering på gaden, der dog aldrig er blevet bekræftet af Google selv. Samtidig er det værd at bemærke, at der siden 2020 har været relativt meget ro på udsvingene i søgemaskinens rangeringer. Det seneste peak i grafen ligger i starten af august, hvor der her var en brand i nogle af Googles servere i USA. Denne hændelse påvirkede søgemaskinens evne til at rangere søgeresultater, og det var derfor ikke en opdatering, der var skyld i udsvinget.

Opdateringerne bliver mindre og mindre omfattende med tiden, og udsvingene bliver derfor også derefter. Google Dance er ikke længere en ting, men det gør det ikke mindre væsentligt at følge med i hvad der sker på Google.

I august kom det frem, at Google stod klar med sidste nye update på stammen: Googles Helpful Content Update. Denne update er langt fra den første, og vil næppe heller blive den sidste. Men hvad er det, disse Google core updates går ud på, og hvorfor bliver de ved med at komme?

I august kom det frem, at Google stod klar med sidste nye update på stammen: Googles Helpful Content Update. Denne update er langt fra den første, og vil næppe heller blive den sidste. Men hvad er det, disse Google core updates går ud på, og hvorfor bliver de ved med at komme?